Tristan Harris, współtwórca ruchu Time Well Spent, oraz Center for Humane Technology przedstawili wczoraj nowy, ambitny program rewolucji w podejściu do technologii. Czas skończyć z „downgrading humans” oraz „extractive attention economy”.

Ten wpis to szybkie streszczenie konferencji „Humane. A new agenda for tech” zorganizowanej przez Center for Humane Technology. Wszystkim zainteresowanym polecam obejrzenie pełnego zapisu – to tylko niewiele ponad godzina. Możliwe, że o tej konferencji kiedyś będziemy czytać w książkach historycznych.

CHT Presents Humane: A New Agenda for Tech from Center for Humane Technology on Vimeo.

Na wczorajszą konferencję zaproszono 300 liderów opinii z branży technologicznej – przedstawicieli funduszy VC, projektantów i dziennikarzy (w pierwszym rzędzie zauważyłem Steve’a Wozniaka).

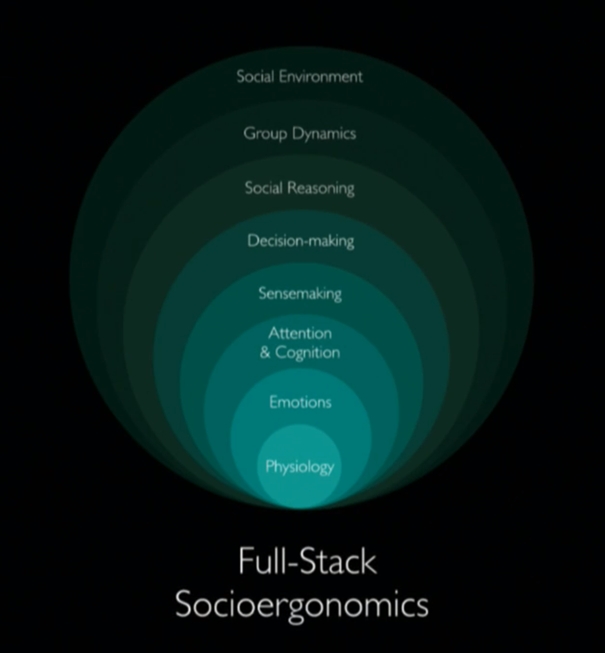

Wydarzenie rozpoczął Aza Raskin wspominając swojego ojca, Jefa, współtwórcę projektu Macintosh w Apple i eksperta w dziedzinie interfejsów. Jef ukuł termin cognetics – ergonomia umysłu. Tak, jak mamy szkielet i układ mięśniowy, które umożliwiają przyjmowanie określonych pozycji (np. kolana zginają się w jedną stronę), tak samo jest z naszymi umysłami. W czasach pierwszego Macintosha korzystanie z technologii przypominało wchodzenie do ciasnego pudełka, które uwierało nasz umysł, wymagało bolesnego dopasowania się. Obecnie technologie cyfrowe są wszędzie, otaczają nas, ściskają, gniotą nasze umysły. Owszem, zawsze żyliśmy w systemach społecznych, ale obecnie ¼ czasu spędzamy w sztucznych systemach społecznych, a pozostały czas spędzamy zachowując się ze świadomością istnienia tych systemów. Jeśli ich struktura nie odpowiada działaniu naszych umysłów, cierpimy.

Extractive attention economy

Tristan Harris zaczął od przedstawienia obecnej sytuacji.

There’s this sort of cacophony of grievances and scandals in the tech industry, but there’s no coherent agenda about what specifically is wrong that we’re agreeing on, and what specifically we need to do, and what specifically we want.

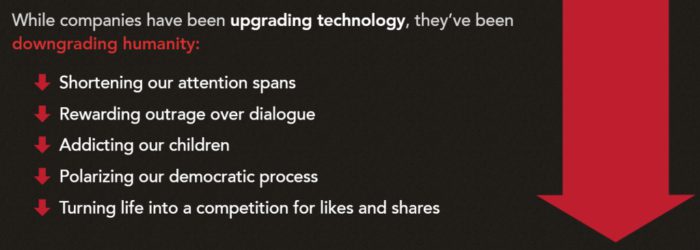

Obecne problemy wynikają z tego, że podczas gdy firmy upgrade’ują technologię, równocześnie downgrade’ują człowieczeństwo (downgrading humanity):

- Skracają naszą zdolność do skupienia uwagi

- Bardziej promują wściekłość niż dialog

- Uzależniają dzieci

- Nakręcają polaryzację polityczną

- Zamieniają nasze życie w rywalizację o lajki

Według Tristana te wszystkie zjawiska są napędzane przez jeden problem podsumowany przez E. O. Wilsona, ojca socjobiologii:

The real problem of humanity is that we’ve got paleolithic emotions, mediaval institutions, and god-like technology.

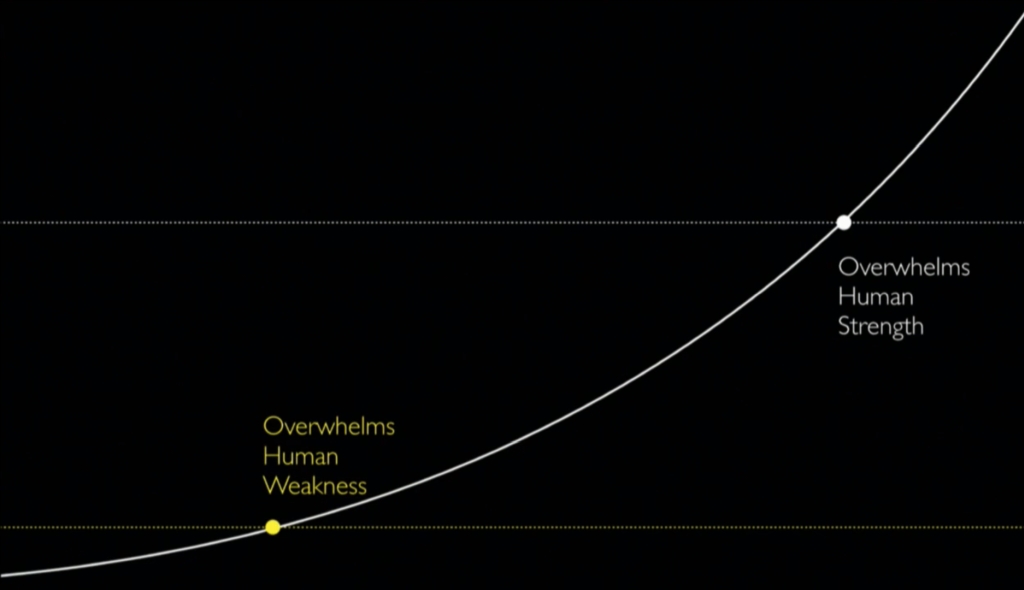

Skupiliśmy się na obserwowaniu, kiedy rozwój technologiczny doprowadzi do tego, że maszyny pokonają ludzkie zdolności.

Tymczasem nie dostrzegliśmy, że nastąpił już moment, gdy technologia pokonała ludzkie słabości. Przykładem są m.in. oszukujące nas roje botów, przeładowanie informacyjne, algorytmy przekonujące nas do marnowania czasu oraz polaryzacja polityczna.

Obecnie żyjemy w systemie społeczno-gospodarczym, który Tristan nazwał

extractive attention economy

Trwa wyścig do dna naszego gadziego umysłu, wyścig w hakowaniu i inżynierii wstecznej naszych ludzkich instynktów. Każda aplikacja musi stosować maksymalną liczbę sztuczek, błędów poznawczych i ludzkich słabości, aby przykuć naszą uwagę bardziej niż aplikacje konkurencji. Degradacji ulega nawet nasza wolna wola – decydujesz się na zobaczenie jednego filmu na YouTube, ale aplikacja uruchamia kolejne.

Free will has been colonised

Każdy z gigantów technologicznych ma na swoich serwerach odpowiadające każdemu z nas laleczki voodoo – to nasze profile zbudowane na podstawie zgromadzonych danych. Firmy wbijają szpilki w te laleczki, a my zachowujemy się tak, jak to wynika z naszego profilu. A algorytmy są „przechylone” tak, aby wydobywać jak najwięcej naszej uwagi.

Na YouTube są filmy spokojne oraz szalone i to te ostatnie silniej przykuwają naszą uwagę. Właśnie dlatego nastolatce, która szuka filmów o diecie polecone zostaną filmy o anoreksji, a zainteresowanym lądowanie na Księżycu algorytm zarekomenduje dowody na to, że Ziemia jest płaska.

Mogę poklepać się po plecach – Tristan krytykuje to samo, o czym również ostatnio myślałem. Otóż obecne metody, jakie firmy tech stosują w celu moderowania treści i korygowania algorytmów, nie skalują się. 10 tys. moderatorów nigdy nie zapanuje nad treściami tworzonymi przez 2 miliardy ludzi. Skala problemów na całym świecie jest ogromna, tymczasem firmy skupiają się na pojedynczych zjawiskach (zupełnie przypadkiem chodzi tylko o te podchwycone przez anglojęzyczne media). Czy ktoś w Facebooku lub YouTube zajmuje się treściami spiskowymi po arabsku?

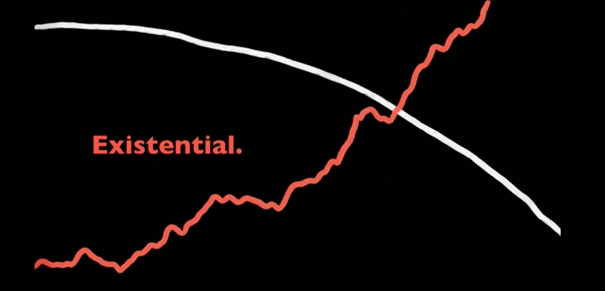

Jeśli nie zmienimy systemu, to będzie jeszcze gorzej, bo w ciągu 6 lat do tego patologicznego internetowego środowiska dołączy kolejnych kilka miliardów ludzi. Z jednej strony narastają wyzwania, z jakimi zmaga się ludzkość, jak zmiany klimatu czy nierówności. Z drugiej strony spada nasza zdolność do porozumienia, kompromisu i wspólnego rozwiązywania problemów. To zagrożenie dla egzystencji ludzkości, existential threat.

Powinniśmy to zmienić. Natychmiast.

Wyszarzenie ekranu smartfona nie wystarczy

Tristan i jego współpracownicy stworzyli ruch Time Well Spent, który doprowadził do powstania aplikacji pomagających walczyć z manipulacyjnymi technikami projektantów. W jednym z wywiadów zalecał przełączenie ekranu smartfona na odcienie szarości, aby zmniejszyć oddziaływanie barw (ja też to zrobiłem!). Wczoraj jednak Tristan wyśmiał wszystkie te metody jako niewystarczające i kompletnie nieproporcjonalne do skali wyzwań. Problem jest systemowy i potrzebuje systemowych rozwiązań. Skrytykował też inne metody, począwszy od uczenia designerów etyki, przez płacenie użytkownikom za nasze dane, („to tak jakby rozwalający wszystko Frankenstein rzucał w nas drobniakami”), po silniejszą ochronę danych użytkowników („oni już nie potrzebują naszych danych, bo znają nas tak dobrze”). Projektowane rozwiązania powinny odpowiadać nie tylko na ludzkie potrzeby, ale także uwzględniać ludzkie słabości.

The problem with human centered design is that it puts human bugs at the center.

To czego potrzebujemy to:

Full stack understanding how we realy work.

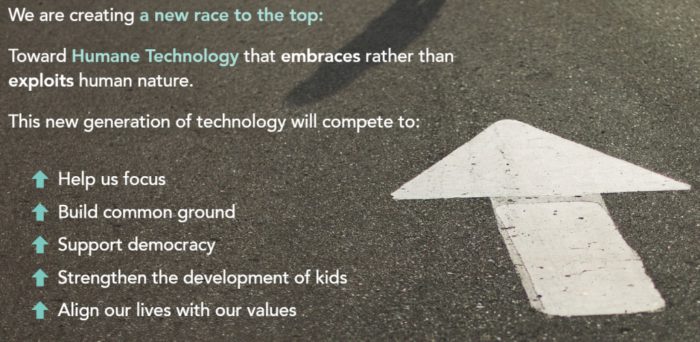

Nowa spójna agenda dla technologii powinna tworzyć zachęty do wzmacniania konkurencji w rozwiązywaniu problemów ludzkości, podobnie jak obecnie tworzy się zachęty, aby rynek wspierał walkę ze zmianami klimatycznymi.

Ale co z modelami biznesowymi obecnych gigantów tech?

Free is the most expensive business model we’ve ever created.

Tristan podał kilka przykładów, jak inaczej można podejść do projektowania, gdy zmieni się cele, do których dążą twórcy aplikacji.

- Co jeśli otrzymywanie wsparcia od bliskich byłoby tak samo łatwe, jak znajdowanie informacji na Wikipedii?

- Co jeśli równie łatwe byłoby znajdowanie wspólnej płaszczyzny z innymi użytkownikami? Co jeśli Facebook i Twitter byłyby zaprojektowane, aby to ułatwiać, np. poprzez mniejsze grupy i odpowiednią facylitację?

Odniósł się także do AI. Jeśli istnieje narzędzie posiadające tak ogromną władzę, że potrafi manipulować zachowaniem 2 miliardów ludzi, to powinniśmy być pewni, że działa ono w naszym interesie. O ile zwykle nie zgadzam się z ludźmi, którzy twierdzą, że żyjemy w wyjątkowych czasach technologicznej rewolucji, to jednak zgadzam się z Tristanem mówiącym o historycznym momencie, w jakim obecnie się znajdujemy. Stworzyliśmy bowiem technologię, która potrafi symulować kukiełkową wersję swojego stwórcy i ta kukiełka potrafi kontrolować swojego pana.

This could be the end of human agency.

Jeśli jednak jesteśmy świadomi, co się dzieje, zyskujemy wybór i możliwość działania. Ok, to skoro już jesteśmy świadomi, to zaprojektujmy świat, w jakim chcemy żyć – i temu służy nowa agenda dla technologii.

Dlaczego może się udać?

Tristan i Humane Tech wierzą, że zmiana jest możliwa. Gdy w 2013 Tristan próbował zmieniać Google od środka, czuł się kompletnie bezsilny. W 2015 roku wystąpił na TED. W 2017 zmiany zaczęły być widoczne, pojawiła się polityczna presja na firmy technologiczne, coraz więcej liderów opinii mówiło o problemach. W 2018 roku już 72% amerykańskich nastolatków uważa, że firmy tech manipulują nimi, aby spędzać więcej czasu z urządzeniami. Równocześnie Facebook, Google i Apple wprowadzają kolejne rozwiązania wpisujące się w ruch Time Well Spent, a portal the Verge ogłosił:

The Time Well Spent debate is over. (Time Well Spent won)

Tristan przyznaje, że to dopiero małe kroki, ale udało się zapoczątkować zmianę, która jeszcze kilka lat temu była trudna do wyobrażenia.

W najbliższym czasie mają zostać opublikowane narzędzia dla projektantów (design guide), podcast, a w 2020 roku ma odbyć się konferencja. Tymczasem polecam odwiedzenie https://humanetech.com/resources

Co każdy z nas może zacząć robić już teraz?

- Zespoły produktowe – zacząć korzystać z full-stack humane design.

- Pracownicy tech – odważnie zabierać głos.

- Dziennikarze – zwracać uwagę na problemy i rozwiązania systemowe.

- Wyborcy – domagać się przeciwdziałania human downgrading

- Politycy – chronić obywateli poprzez zmianę zachęt dla firm

- Udziałowcy – domagać się od spółek odchodzenia od human downgrading

- Inwestorzy – inwestować w firmy wspierające pozytywną zmianę.

- Przedsiębiorcy – tworzyć produkty, które uwzględniają skomplikowaną naturę ludzi.

- Giganci tech – zacząć rywalizować o nasze zaufanie i wartości, a nie uwagę.

Zmiany wydają się naprawdę realne. Kilka dni temu amerykańscy senatorzy przedstawili projekt DETOUR Act, który ma zwalczać „dark patterns design”.